作者:Jason Feist,希捷科技云业务营销高级副总裁

随着ChatGPT、Genesis和Claude等大型语言模型的崛起,全球数据生成量呈现爆发式增长。IDC预测,到2028年全球创建、获取、复制和消费的数据总量将达到394ZB。

当前,大模型领域的竞争已全面展开——从硬件架构到软件算法的各个层面,厂商都在展示技术实力。而拥有海量数据存储经验的云服务商们,正通过优化硬盘与固态硬盘的混合存储架构,为规模化AI分析提供支撑,并推出一系列创新AI应用。

一、AI如何重塑数据存储及其演进需求

随着数据的爆炸式增长,生成式人工智能应用日益普及。更加丰富的内容形态、更多次的数据复制和转换、更长的数据保留时间以及数据监管和数据主权要求的升级,共同催生了更庞大的数据创建和存储需求。

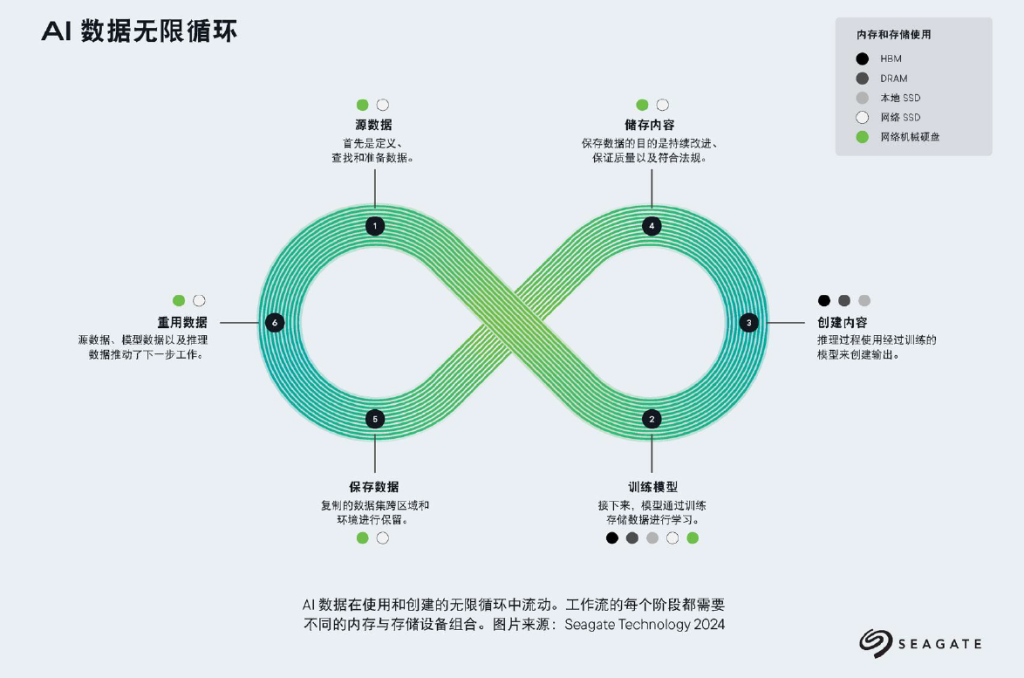

数据已成为AI成功的核心要素,其在希捷提出的“AI数据无限循环”中流经六大节点:源数据、训练模型、创建内容、存储内容、保存数据和重复利用数据。每个阶段都需要差异化的存储方案组合:

AI模型的训练、后处理及微调过程天然需要消耗大量数据和存储资源,尤其是各行业特有的非公开数据集,这些数据对开发具有领域针对性的AI系统至关重要。虽然并非所有AI应用都需要“无限”的数据支撑,但现代深度推理系统的有效性很大程度上依赖于大规模高质量数据集——随着AI技术向新领域拓展,这种依赖性愈发显著。当前的一个关键趋势是:在推理能力进步和成本优化部署的双重推动下,以往未被充分利用的数据源(如医疗领域的患者病历、能源勘探中的地震数据等行业记录和现实场景数据)正被整合到AI工作流程中。这一转变使得曾被边缘化的数据类别融入AI核心应用范畴,进一步刺激市场扩张。

鉴于AI在现代数据生态中的无处不在,“通用数据”与“AI专用数据”正在融合为单一类别——这场变革将以指数级速度加速全球数据领域的扩张。

二、数据存储在AI工作流中的关键作用

AI工作流是由多个复杂环节组成的完整过程,每个阶段都需要专门的存储解决方案支撑。从数据预处理、模型训练、推理部署到长期归档,不同环节对存储性能、容量和成本效益各有侧重。随着AI系统的持续演进,存储技术必须同步创新,在确保可扩展性、效率与可靠性的同时,满足这些动态变化的需求。

1、源数据:AI成功的基石

人工智能模型的有效性取决于能否访问来自不同来源的海量高质量数据集,因此存储架构必须能够超越“SSD=快/HDD=慢”这种简单的二分法。如今的高密度机械硬盘已发展成为大规模AI工作流的高效组件,它们不仅作为冷存储层存在,更是分布式缓存系统的活跃参与者。凭借无可匹敌的容量成本比,HDD实现了EB级甚至更大规模数据操作的可持续扩展。

当前,行业领导者已在需要超高吞吐量和持久数据可用性的地理分布式AI/ML部署中采用HDD,充分证明其与SSD共同构成了现代存储体系的核心支柱。这些架构实践表明,经过创新的HDD技术已从昔日的“传统”存储介质,蜕变为可扩展AI基础设施的关键基石。

2、模型训练:存储需求的核心战场

训练诸如ChatGPT或GROK等大型语言模型(LLM)需要反复访问PB级数据,这对存储系统提出了双重挑战——既要满足梯度计算所需的高速访问,又要保障数据集持久化存储的大容量需求。在这一计算密集型阶段,高性能存储架构通常采用HBM、DRAM 和本地SSD进行学习。

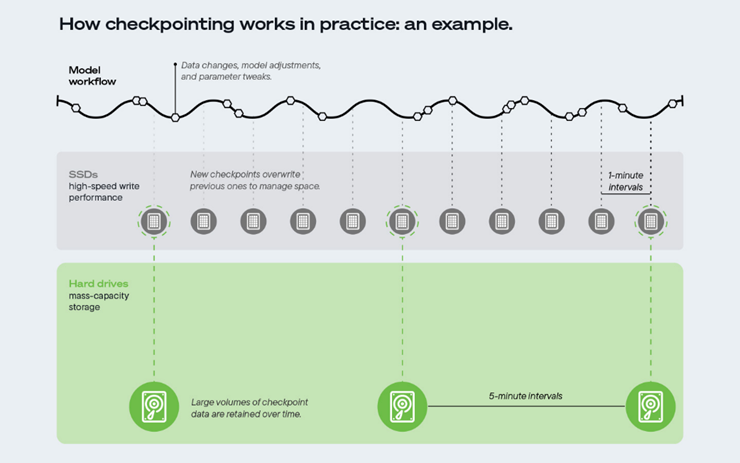

检查点具体发生在模型训练阶段。它通过定期保存包含模型数据、参数和配置设置的完整快照,为训练过程提供多重保障。这些检查点不仅可以作为防止意外中断的保障措施,避免训练进度丢失,还能完整记录模型参数的演化轨迹,为开发者提供宝贵的记录依据。为确保检查点的安全存储与高效访问,业界普遍采用网络硬盘和SSD存储检查点以保护和改进模型训练。

模型训练期间的数据保留呈现出明显的阶段性特征。如图所示,模型工作流程会持续生成数据变更和参数调整,高速SSD会频繁执行快速检查点写入,同时覆盖先前的数据以满足实时性要求。这种高频覆盖机制可确保高效的训练进程,这意味着活跃的训练数据通常仅保留几分钟。相比之下,大容量HDD则承担着长期存储的职责,将海量检查点数据集保存数周甚至数月,从而维护全面的历史档案。

3、推理与内容生成:速度与经济性的兼顾

在推理阶段,AI系统需实时响应各类查询请求(如聊天机器人、推荐引擎等),这就要求存储系统在实现微秒级数据访问的同时保持成本可控。支撑这一持续创作过程的核心存储技术包括:HBM、DRAM和本地SSD。

4&5、内容存储与留存:耐用性与合规性并重

AI生成内容(如合成媒体、学术论文及大规模数据集)在产出后,需要满足三大核心要求的长期存储方案:超大容量、能源高效与合规留存。随着各行业AI生成内容的爆发式增长,可扩展存储基础设施的需求呈指数级上升。这类技术不仅能显著降低运营成本,还可有效减少碳足迹,与全球可持续发展目标高度契合。

此外,要确保数据长期完整性,必须采用先进纠错协议并实施定期完整性校验,从而有效防止数据劣化或过时问题。合规性要求更进一步增加了存储策略的复杂性——不同司法管辖区对数据留存期限、可访问性及隐私保护的规定往往存在差异。通过将可扩展的节能存储方案与完善的合规框架相结合,企业既能使其AI产出具备前瞻适应性,又能满足持续演进的监管要求与环保标准。

像英国国家档案馆这样需要长期保存PB级数据(20年合规留存)的大规模AI项目,必须采用能够兼顾性能与容量的存储架构。总部位于美国的Iron Mountain公司协助英国国家档案馆部署了AI及机器学习系统,该方案能自动识别符合永久保存要求的档案,从而满足留存20年的规定。该系统可以完成记录筛选、重复项检测、实体提取及文件评估等全流程处理,最终确定归档内容。

6、数据再利用:源数据、模型数据和推理数据将助力下一步工作

内容输出反馈到模型中,从而提高其准确性并赋能新模型。网络硬盘和固态硬盘为跨地域的AI数据协同生产提供支撑,使原始数据集与处理结果能持续转化为新工作流的输入源。

AI技术的下一前沿不仅关乎算法优化,更在于重构数据存储、访问与再利用的全流程范式。展望未来,数据中心运营商需重点考量三大战略方向:重新评估数据留存策略以保留曾被丢弃但具潜在价值的数据集;推动基础设施从集中式向分布式-解耦架构演进;优化功耗、服务等级协议(SLA)与可扩展性的三角平衡。这些决策将直接决定AI系统如何有效地充分利用其数据潜力。

作为全球领先的EB级存储解决方案供应商,希捷一直走在满足日益增长的数据存储需求的前沿。

希捷最新推出的魔彩盒3+(Mozaic 3+)平台彰显了公司对创新的执着追求,为可扩展的AI解决方案提供了清晰路径。这一尖端技术平台助力客户能够高效扩展其存储基础架构,优化总体拥有成本,并实现可持续发展目标。在AI驱动的数据中心,高存储容量至关重要,不同的存储介质在性能和可扩展性方面具有不同的优势。希捷的热辅助磁记录(HAMR)技术显著提升了面密度,提升了硬盘的容量、性能和能效,并将实现单碟片10TB的突破性容量。

希捷率先将NVMe技术引入大容量硬盘领域,推出革命性解决方案,该技术已通过试点项目得到验证。通过将NVMe发展为未来硬盘连接标准协议,希捷提供了一种创新选择,既能优化AI数据流水线、减少存储瓶颈,又可保留硬盘在成本与存储密度方面的传统优势。与传统基于SAS/SATA的硬盘相比,NVMe硬盘无需主机总线适配器(HBA)、协议桥接器和额外SAS基础设施,从而显著简化了AI存储架构。尤为关键的是,该技术还支持GPU直接访问。通过在高密度硬盘存储与高速SSD缓存之间构建统一的NVMe架构,从而实现AI工作负载的无缝扩展。

希捷正积极携手客户及AI生态领军企业,共同验证该技术在AI全价值链中的实际效能。此类深度合作将助力构建标准参考架构,从而确立NVMe硬盘在AI基础设施中的长期战略价值。

四、总结

希捷对技术创新的不懈追求,彰显了其在应对现代数据中心不断演进需求中的关键作用。通过持续提升存储容量并推动全行业协作,希捷不仅可以满足当前需求,更为人工智能等领域的未来发展奠定了基础。

随着竞争格局的加剧,企业将倾向于采用能够利用尖端硬件技术并优化配置的架构。在应用性能和投资效率之间取得适当的平衡,对于在这种动态环境中蓬勃发展至关重要。通过实现这种平衡,企业不仅可以跟上技术进步的步伐,还可以推动人工智能和数据存储领域的未来创新。